コミックマーケット80で暑い中ブースを見に来ていただいた方、どうもありがとうございました。

そして、本が売り切れだった方、行ってみたら撤収した後だった方、すみませんでした。

今度からのイベント参加では、十分な数を用意するようにします。

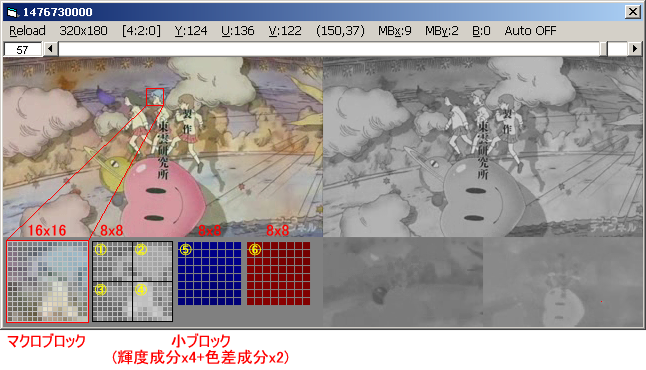

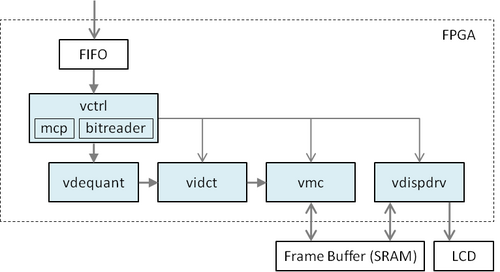

さて、頒布していた本の「FPGA向けMPEG2デコーダ」の記事について、現状のソースコードを公開します。

m2v_dec_impl_r250.zip

1つめはデコーダIP本体、2つめはデコーダIPのテストに用いるソフトウェアデコーダです。

いずれも最初にreadme.txtをお読みください。

現状、

・単体テストは入力データ終端の取り扱いが上手く行かないかもしれません(=テストの最後でデータの取りこぼし等発生するかもしれません)

・結合テストは3フレーム目以降は動かないかもしれません。

・実機ではまだ動きません(ダレカタスケテ...)。回路図等もまだ含まれていません。

と、ひどい有様です。ただ、完璧を目指していてはいつまで経っても公開できないので、

大きな修正がある毎にアップしていきたいと思います。要望が多ければ管理しているsubversionのリポジトリ自体を見てもらえるようにできるかも。

前回のmakeから取り組んでいるプロジェクトなので、やりきってしまいたいですね。もうちょっと頑張ろうと思います。

そして、本が売り切れだった方、行ってみたら撤収した後だった方、すみませんでした。

今度からのイベント参加では、十分な数を用意するようにします。

さて、頒布していた本の「FPGA向けMPEG2デコーダ」の記事について、現状のソースコードを公開します。

m2v_dec_impl_r250.zip

1つめはデコーダIP本体、2つめはデコーダIPのテストに用いるソフトウェアデコーダです。

いずれも最初にreadme.txtをお読みください。

現状、

・単体テストは入力データ終端の取り扱いが上手く行かないかもしれません(=テストの最後でデータの取りこぼし等発生するかもしれません)

・結合テストは3フレーム目以降は動かないかもしれません。

・実機ではまだ動きません(ダレカタスケテ...)。回路図等もまだ含まれていません。

と、ひどい有様です。ただ、完璧を目指していてはいつまで経っても公開できないので、

大きな修正がある毎にアップしていきたいと思います。要望が多ければ管理しているsubversionのリポジトリ自体を見てもらえるようにできるかも。

前回のmakeから取り組んでいるプロジェクトなので、やりきってしまいたいですね。もうちょっと頑張ろうと思います。