ずっとMPEG2の作業ばっかりやっていると、たまに違うことをやりたくなるわけでして。

先週、無性にアートワークがしたくなった時があって、ちょうどあったフリスクの空きケースを見て

思ったわけです。

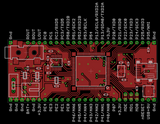

「神は言っている。フリスクサイズのマイコンボードを(ry」

で、ありきたりではありますが、設計してみました。

フリスクケースに収めれば、携帯オーディオプレイヤーに。普通にピンヘッダつければブレッドボードでも使えそうなマイコンボードに。

使ったマイコンは最近秋月で単品販売を始めたルネサスRX(R5F56218BDFP)です。デコード専用IC等は載せません。

検証してませんが、たぶんRXならソフトウェアデコードできるだろう、と思いまして。

回路図はこちら3枚。

なお、今回のマイコンはD/Aが1chしかありませんので、別途D/A (MCP4922)を載せました。

そして、その基準電圧をRXの持つD/Aから出すようにしてみました。MCP4922は

出力段のアンプでゲイン2倍を選べるので、RXのD/A出力を中心に振ることができるうえ、

そのD/A電圧でボリューム調整ができるのでは、と思ったためです。

これでまっとうな音が出るのかは、試してないのでまだ不明です。

※詳しい方、ぜひツッコミいただけると嬉しいです。

とりあえずアナログ部分の試作評価と、ソフトウェアデコードが出来るのかをRX-Stickでも使って検証していきたいと考えています。

先週、無性にアートワークがしたくなった時があって、ちょうどあったフリスクの空きケースを見て

思ったわけです。

「神は言っている。フリスクサイズのマイコンボードを(ry」

で、ありきたりではありますが、設計してみました。

フリスクケースに収めれば、携帯オーディオプレイヤーに。普通にピンヘッダつければブレッドボードでも使えそうなマイコンボードに。

使ったマイコンは最近秋月で単品販売を始めたルネサスRX(R5F56218BDFP)です。デコード専用IC等は載せません。

検証してませんが、たぶんRXならソフトウェアデコードできるだろう、と思いまして。

回路図はこちら3枚。

なお、今回のマイコンはD/Aが1chしかありませんので、別途D/A (MCP4922)を載せました。

そして、その基準電圧をRXの持つD/Aから出すようにしてみました。MCP4922は

出力段のアンプでゲイン2倍を選べるので、RXのD/A出力を中心に振ることができるうえ、

そのD/A電圧でボリューム調整ができるのでは、と思ったためです。

これでまっとうな音が出るのかは、試してないのでまだ不明です。

※詳しい方、ぜひツッコミいただけると嬉しいです。

とりあえずアナログ部分の試作評価と、ソフトウェアデコードが出来るのかをRX-Stickでも使って検証していきたいと考えています。